A Meta néven teszi közzé a kódot a nyílt hozzáférésű mesterséges intelligenciában imagebind, amely előrejelzi az adatok közötti kapcsolatokat, hasonlóan ahhoz, ahogyan az emberek érzékelik vagy elképzelik környezetüket. Míg az olyan képgenerátorok, mint a Midjourney, a Stable Diffusion és a DALL-E 2 szavakat kötnek a képekhez, lehetővé téve vizuális jelenetek létrehozását csupán szöveges leírás alapján, az ImageBind ezen túlmutat. Szöveget, képeket vagy videót, hangot, 3D-s méréseket, hőmérséklet- és mozgásadatokat képes összekapcsolni – és mindezt anélkül, hogy minden alkalommal előképzésre lenne szükség. Ez egy olyan keretrendszer korai szakasza, amely végül képes lesz összetett környezeteket generálni egyszerű bemenetekből, például szöveges promptból, képből vagy hangból (vagy ezek kombinációjából).

Az ImageBind a gépi tanulás emberi tanuláshoz való közelítésének tekinthető. Például, ha dinamikus környezetben, például egy forgalmas városi utcában áll, az agya (többnyire öntudatlanul) elnyeli a látványokat, hangokat és egyéb szenzoros érzeteket, hogy információkat kapjon az elhaladó autókról, magas épületekről, időjárásról stb. . Az emberek és más állatok úgy fejlődtek, hogy feldolgozzák ezeket az adatokat genetikai előnyünk érdekében: a túlélés és a DNS továbbadása érdekében. (Minél többet tudsz a környezetedről, annál jobban el tudod kerülni a veszélyeket, és alkalmazkodhatsz a környezetedhez, hogy jobban túlélj és boldogulj). Ahogy a számítógépek egyre közelebb kerülnek az állatok multiszenzoros kapcsolatainak utánzásához, ezeket a kapcsolatokat arra használhatják, hogy teljesen megvalósított jeleneteket hozzanak létre csak korlátozott adatok alapján.

Tehát bár a Midjourney segítségével létrehozhat egy „basset houndot Gandalf-jelmezben, egyensúlyozva a strandlabdán”, és viszonylag valósághű fotót készíthet erről a furcsa jelenetről, egy multimodális mesterséges intelligencia-eszköz, például az ImageBind elkészítheti a megfelelő videót a kutyával. hangok, beleértve a nappali részletes leírását, a szobahőmérsékletet, valamint a kutya és mindenki más pontos helyét a jelenetben. "Ez kiváló lehetőséget teremt arra, hogy statikus képekből animációkat készítsünk, hangutasításokkal kombinálva" - jegyzik meg a Meta kutatói fejlesztőközpontú blogjukban. "Például az alkotó kombinálhat egy képet egy ébresztőórával és egy kukorékoló kakassal, és egy hangjelzést használhat a kakas szegmentálására, vagy az ébresztőóra hangját, hogy szegmentálja az órát, és animálja mindkettőt egy videósorozatban."

Ami még azt illeti, hogy mit lehet még tenni ezzel az új játékkal, egyértelműen rámutat a Meta egyik alapvető ambíciójára: a VR-re, a vegyes valóságra és a metatérre. Képzeljünk el például egy jövőbeli headsetet, amely menet közben képes teljesen megvalósított 3D-s jeleneteket készíteni (hanggal, mozgással stb.). Vagy a virtuális játékfejlesztők végül arra használhatják, hogy megkíméljék magukat a tervezési folyamat fáradságos munkájától. Hasonlóképpen, a tartalomkészítők lebilincselő videókat készíthetnek valósághű hangsávokkal és mozgással, csupán szöveg, képek vagy hang alapján. Azt is könnyű elképzelni, hogy egy olyan eszköz, mint az ImageBind, hogyan nyit új ajtókat a kisegítő lehetőségek terén azáltal, hogy valós idejű multimédiás leírásokat generál, amelyek segítségével a látás- vagy hallássérült emberek jobban megérthetik környezetüket.

Szintén érdekes: A legjobb mesterséges intelligencia alapú eszközök

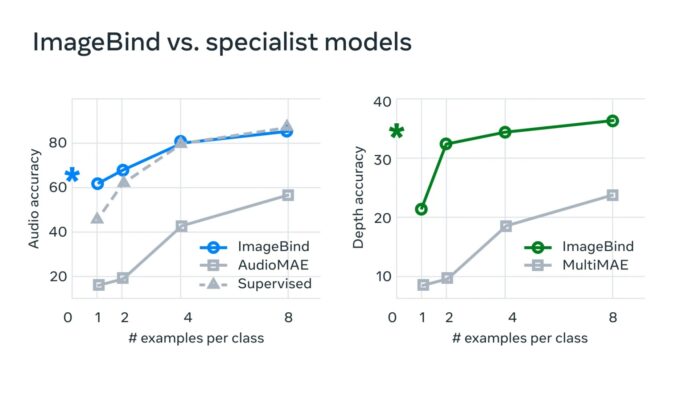

„A tipikus mesterséges intelligencia rendszerekben minden releváns modalitáshoz létezik egy speciális beágyazás (azaz olyan számvektorok, amelyek az adatokat és azok kapcsolatait reprezentálják a gépi tanulásban)” – mondja Meta. „Az ImageBind megmutatja, hogy lehetséges közös beágyazási teret létrehozni több modalitás számára anélkül, hogy a modalitások minden egyes kombinációjával az adatokra kellene oktatni. Ez azért fontos, mert a kutatók nem hozhatnak létre adathalmazokat olyan mintákból, amelyek például hang- és hőadatokat tartalmaznak egy forgalmas városi utcáról, vagy mélységadatokat és egy tengerparti szikla szöveges leírását.”

A Meta úgy véli, hogy ez a technológia végül túlmutat a jelenlegi hat „érzéken”, hogy úgy mondjam. "Bár jelenlegi tanulmányunkban hat módozatot vizsgáltunk meg, úgy gondoljuk, hogy olyan új módozatok bevezetése, amelyek a lehető legtöbb érzékszervet összekapcsolják – például érintés, beszéd, szaglás és fMRI agyi jelek – gazdagabb emberközpontú AI modelleket tesz lehetővé." Az új homokozó felfedezése iránt érdeklődő fejlesztők a Meta nyílt forráskódjának megismerésével kezdhetik.

Olvassa el még: