Vállalat Apple visszavonja vitatott fotószkennelési funkciójának elindítását a gyermekekről készült illegális fotókhoz, egy olyan rendszerhez, amely az iCloudba és az iMessage chatekre feltöltött fényképeket kellett volna megvizsgálnia illegális szexuális tartalom nyomai után. A múlt hónapban bejelentett rendszernek a gyermekek szexuális zaklatását tartalmazó anyagok (CSAM) harmadik féltől származó adatbázisát kellett volna használnia a felhőbe feltöltött illegális fotók nyomainak keresésére, de azonnal ellenállásba ütközött a magánélet védelmezői által.

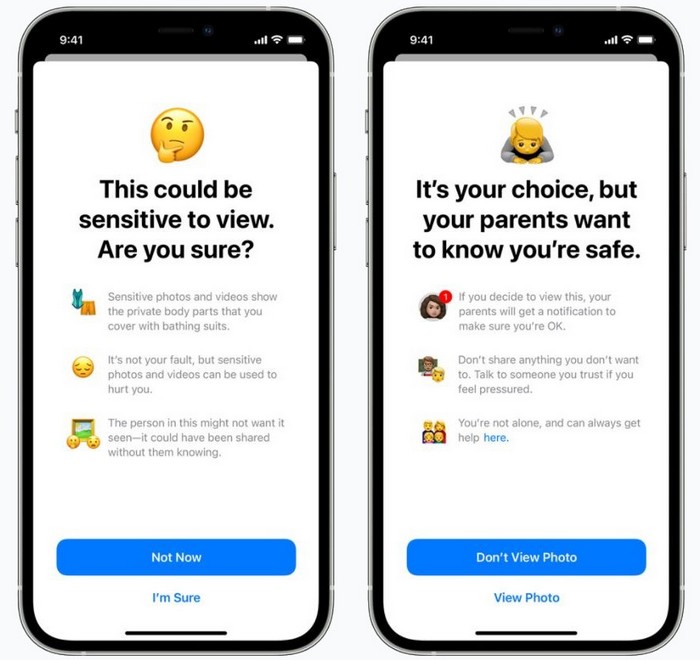

A zavart tetézte az a tény Apple valójában két rendszert jelentett be egyszerre, bár ezek funkcionalitása sok helyen vegyes volt. Egyrészt az iMessage képfelismerést használ a fiatalabb felhasználókkal folytatott beszélgetések során megosztott, potenciálisan őszinte fényképek megjelölésére. Ha egy ilyen kép nyilvánossá válik, automatikusan cenzúrázzák, és lehetőség szerint a szülők értesítést kapnak a tartalmáról.

Ugyanakkor egy másik rendszer ellenőrizné a CSAM-ot. Csak a cég iCloud Photos szolgáltatásába feltöltött képeket figyelnék Apple, szakértő ügynökségek által készített ujjlenyomat-képek felhasználásával, hasonló illegális tartalmú adatbázis alapján. Ha több ilyen képet észlel, Apple jelentené az ilyen felhasználót a hatóságoknak.

Figyelembe véve az adatvédelmi és biztonsági aggályokat, Apple számos figyelmeztetéssel szolgált. A szkennelés a készüléken történik, nem távolról – jegyezte meg a cég, és az ujjlenyomatok, amelyekhez a képeket összehasonlítják, nem tartalmaznak illegális tartalmat. Még ha a feltöltött képeket meg is jelölik, a jelentés összeállítása előtt egy ember felülvizsgálja azokat.

Az újítások ellenzői azonban elszántak voltak. Rendszer Apple Csúszós pálya – figyelmeztettek –, és a cupertinói cég – annak ellenére, hogy az ellenkezőjét állítja – kétségtelenül szembe kell néznie a rendfenntartó szervek és a kormányok nyomásával. Megállapították, hogy a fiatalok is veszélyben lehetnek, és a magánélethez való joguk sérülne, ha Apple véletlenül LMBT-ként továbbadja őket szüleiknek az iMessage szkennelő rendszeren keresztül.

A cég alkalmazottaitól, vezetőitől kapott nem hivatalos információk szerint Apple megdöbbentette a visszahatás mértéke és az, hogy mennyi ideig tartott. Most Apple megerősítette, hogy idén már nem indít új rendszereket az iOS 15, iPadOS 15, watchOS 8 és macOS Monterey mellett.

"Múlt hónapban bejelentettük, hogy olyan funkciókat vezetünk be, amelyek célja, hogy megvédjék a gyerekeket a kommunikációs eszközöket toborzásra és kizsákmányolásra használó ragadozóktól, és korlátozzuk a gyermekek szexuális zaklatását tartalmazó anyagok terjesztését" - áll a közleményben. Apple. "Az ügyfelektől, érdekképviseleti csoportoktól, kutatóktól és másoktól kapott visszajelzések alapján úgy döntöttünk, hogy az elkövetkező hónapokban további időt szánunk az információgyűjtésre és a fejlesztésekre, mielőtt kiadnánk ezeket a kritikus gyermekbiztonsági funkciókat."

Az egyértelműség kedvéért nem az új CSAM-rendszerek teljes megszüntetéséről beszélünk, csupán egy késésről. Valószínűleg azonban győzelemnek fogják tekinteni a magánélet védelmezői, akik bár felismerték, hogy meg kell védeni a gyerekeket a ragadozó viselkedéstől, kételkedtek abban, hogy a széles körben elterjedt szkennelés a legjobb módja ennek.

Olvassa el még:

- Apple lehetővé teszi más fizetési rendszerek használatát az App Store-ban

- Apple az USA-ban elsőként 2,5 billió dollárra drágult